陳霄鵬,彭亞雄,賀松

(貴州大學 大數據與信息工程學院, 貴州 貴陽 550025)

摘要:隨著時間的變化,人的聲音也會發生變化。這對說話人的識別帶來了一定的影響。通過研究發現,說話人識別的性能與時間有著線性變化的規律。傳統的說話人識別系統使用GMMUBM模型并不能很好地學習出線性變化規律。由于概率線性判別分析(PLDA)對于類內與類間有著很好的線性區分度,所以為了解決線性變化的問題,選擇概率線性判別分析的方法學習說話人識別中時變的線性變化規律。從實驗結果看出,PLDA對于說話人識別的識別魯棒性具有很好的提升。

0引言

說話人識別即聲紋識別,為生物特征識別的一種。而聲紋這一概念從誕生之初就一直伴隨著其是否隨時間變化的質疑。經過多年的研究發現,聲紋識別確確實實隨著時間發生變化。早在2003年,Bonastre教授已發表論文指出說話人識別的時變問題。在實際的說話人識別系統中,聲紋預留與聲紋驗證之間的時間間隔也帶來了系統性能的下降。

在已有的研究中,浙江大學CNNT實驗室設計了一個聲紋打卡系統,記錄了實驗室成員每天打卡情況,其中在開始的50天里識別率為69.02%,在稍近的幾天里識別率提高到了74.19%。同時提出了平滑化梅爾倒譜系數(Smoothing Mel Cepstrum Coefficient, SMFCC )這種更穩定的特征提高時變魯棒性。

清華大學語音和語言技術中心王琳琳博士以Fratio作為中間準則計算頻帶區分度從而提高其魯棒性。同時還提出了性能驅動的頻率彎折方法的特征提取算法。

以上研究都基于特征層面,并未涉及到模型層面,本文研究著重于模型層面。

1說話人識別的線性變化規律

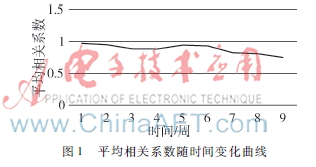

隨著時間的變化,人的聲音也會發生變化,從而影響說話人識別的識別率。其識別率會降低,而這種降低類似線性變化。所以,假設說話人識別中不同時間的特征之間的線性相關,通過特征之間的相關系數可以判別兩個特征之間的線性相關性。根據實驗結果發現,相關系數都在0.7~1之間,也就說明特征與特征之間有著極大的線性相關性。而且相關系數隨著時間的變化也有著相對的線性變化。實驗結果如圖1。

為了更加準確地描述時間變化的規律,最大可能排除音素沒有對齊的影響,故而選擇動態時間規整(Dynamic Time Warping, DTW)對特征進行分析。將動態時間規整后的兩段語音求cosine距離,根據cosine距離觀察兩段語音的相似程度。實驗結果表明,cosine距離隨著時間的變化也呈現出相應的線性變化。實驗結果如圖2。

由以上兩個實驗結果可以得出,隨著時間的變化,說話人識別的魯棒性呈線性變化規律。

2概率線性判別分析

說話人識別是模式識別的一種,分為訓練和識別兩個階段。訓練可以認為就是將語音按照不同的人進行分類,每一類代表了一個人,識別就是將測試的語音與已經分好類的模型進行比對。在說話人識別中加入時間的變化,就要同時考慮同一類的變化,即類內的變化,以及類與類之間的變化,也即類間的變化。

線性概率判別分析[13](Linear Discriminant Analysis,LDA)是一種將類內和類間的方差作為多維高斯分布的一種技術,它尋求方向空間最大的辨別力,因此非常適合支持類的識別任務。

假設訓練數據為不同的I個人,且每個人有J個語音,xij表示第i 個人的第j個語音,則LDA模型可表示為:

xij=μ+Fhi+Gwij+ij(1)

此模型分為兩個部分:第一個部分μ+Fhi只與每個個體的特征有關,而與每條語音的特征無關;第二個部分Gwij+ij指每個個體語音的不同以及代表個體內部的噪聲。其中μ為訓練數據集的總體平均數;矩陣F的列包含了個人之間子空間的主要成分;hi代表這個子空間的位置;矩陣G包含了個體內部子空間的主要成分;wij代表這個子空間的位置;ij定義為高斯對角線協方差Σ(殘差)。從條件概率方面來描述式(1)的模型:

Pr(xij|hi,wij,θ)=x[μ+Fhi+Gwij,Σ](2)

Pr(hi)=h[0,I] (3)

Pr(wij)=w[0,I](4)

式a[b,C]中,a為變量,b為期望,C為方差的高斯分布。式(2)~式(4)都是同樣的高斯分布。

2.1訓練階段

訓練階段的主要目標是得到一組數據點xij,并且得到相應的參數θ={μ,F,G,Σ}。如果知道隱藏變量hi和wij的值,這個問題將變得十分簡單。同樣地在給定θ的情況下也很容易估計hi和wij。但是式(1)中的很多參量都是未知的。

使用EM算法[45]可以解決這個問題。EM算法通過迭代輪流估計兩個參數。在Estep,計算出整個后驗分布中的隱藏變量hi和wij,從而修正參數的值。在Mstep,使參數θ={μ,F,G,Σ}的點估計最優化。

2.2識別階段

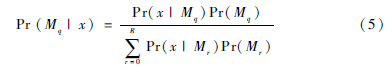

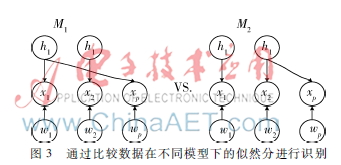

在識別階段,需要比較數據在R個模型M1…R下的似然分。定義模型M代表了隱藏身份變量hi和數據的一種關系。如果測試集中的多條語音屬于同一個人,那么這些語音就需要一個相同的身份變量hi。反之如果多條語音對應了多個人,那么就需要不同的身份變量。因此需要得到第q個模型的似然分Pr(X|Mq),其中X是所有的觀察數據。為了計算每個模型的后驗概率,需要使用貝葉斯準則[68]:

為了更真實地描述這個公式,假設訓練語音為x1、x2,測試語音為xp。如圖3所示,圖中有兩個模型,模型M1的測試語音xp與訓練語音x1相匹配,則它們有著相同的身份變量h1[910]。同樣地,模型M2的測試語音xp與訓練語音x2相匹配,則它們就有著相同的身份變量h2。用下式計算數據在模型M1下的似然分:

Pr(x1,2,p|M1)=Pr(x1,p|M1)Pr(x2|M2) (6)

其中隨機變量x1,p和x2是相互獨立的。此處目標是求出觀測數據的似然分,然而隱藏變量h和w都是未知的[1011]。提取出所有關鍵的觀測似然分和已知的隱藏變量,忽略未知的隱藏變量,從而可以得到:

Pr(x1,p|M1)=Pr(x1,xp,h1,w1,wp)dh1dw1dwp(7)

進一步可以得到:

Pr(x1,p|M1)=∫[∫Pr(x1|h1,w1)Pr(w1)dw1

∫Pr(xp|h1,wp)Pr(wp)dwp]Pr(h1)dh1(8)

同樣地,可以得出關于x2的條件概率:

Pr(x2|M1)=Pr(x2|h2,w2)Pr(w2)dw2Pr(h2)dh2(9)

以上條件概率所描述的都是最開始所定義的高斯分布,即式(1)~式(4)。同樣地,模型M2可以用相同的方法做分解。

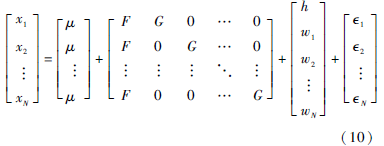

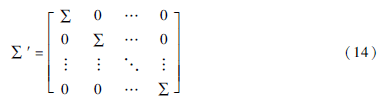

在計算式(8)、式(9)的積分時,算出N條語音匹配相同參數h的似然分,同時忽略了噪音參數w1...wN,加之PLDA是一種線性的高斯分布,所以可以將N條語音識別的系統按照式(1)寫成下面的等式:

將上式重新命名為:

x′=μ′+Ay+′(11)

Pr(x′|y)=x′[Ay,∑′](12)

Pr(y)=y[0,I](13)

其中:

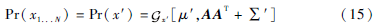

式(12)、式(13)即為標準的因素分析形式,而這種方法是已知的:

實際中,在已知矩陣A結構的前提下,可以提高計算效率。

3實驗

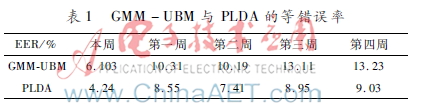

實驗采用GMM-UBM與PLDA進行比較。兩種算法均采用采樣率為16 kHz的語音和39維的MFCC特征,MFCC特征由基本的13維MFCC特征加上其一階導數和二階導數組成。其中MFCC的幀寬為24 ms,幀移為12 ms,預加重系數為0.97,MFCC濾波器組數目為30,低頻截止頻率為60 Hz,高頻截止頻率為3 600 Hz,DCT數目為16。同時增加有效語音檢測(Voice Activity Detection, VAD),取得有效音。對連續四周的語音進行測試,以等錯誤率(Equal Error Rate, EER)為判別標準。EER為錯誤拒絕率(False Rejection Rate,FRR)和錯誤接受率(False Acceptance Rate,FAR)相等的點。實驗結果如表1。

其中本周測試表示以當前周的訓練語音建立模型,用當前周的測試語音進行測試。第一周的結果表示的是以當前周的語音為訓練語音,以當前周的下一周的測試語音進行測試。后三周的測試方法與第一周的測試方法相同。

由表1實驗結果可以看出,說話人識別的時變魯棒性具有線性變化規律,隨著時間的推移,不論是GMMUBM[12]還是PLDA[13],在不同周的測試效果均在逐步降低,但是PLDA的整體效果均優于GMMUBM。從時變的魯棒性來看,PLDA的EER從第一周到第四周表現比較平穩,均保持在9%左右,而GMM_UBM在第三周開始有了明顯的增加,也就是說GMMUBM的魯棒性有所降低。

4結束語

本文通過使用PLDA模型對說話人識別進行了測試,目的在于解決時變的魯棒性問題,從實驗結果來看,PLDA對時變的魯棒性有很大的提高。本文中使用PLDA和GMMUBM對語音進行了測試,以GMMUBM為基線,從測試結果來看,PLDA的整體效果均優于GMMUBM。以后可以使用PLDA為基線,通過對PLDA的改進來進一步提高時變的魯棒性。

參考文獻

[1] YOUNG S. A review of largevocabulary continuousspeech recognition[J]. Signal Processing Magazine, IEEE, 1996, 13(5): 45.

[2] LIANG L, RENALS S. Probabilistic linear discriminant analysis for acoustic modelling[J]. IEEE Signal Processing Letters, 2014,21(6):702706.

[3] CHEN L F, LIAO H Y M, LIN J C, et al. A new LDA-based face recognition system which can solve the sample size problem[J]. Pattern Recognition, 2000, 33(10): 17131726.

[4] RUBIN R, THAYER D. EM algorithms for ML factor analysis[J]. Psychometrika, 1982,47(1):6976.

[5] GHARAMANI Z, HINTON G E. The EM algorithm for mixtures of factor analyzers[R]. University of Toronto Technical Report, 1997.

[6] DEHAK N, KENNY P J, DEHAK R, et al. Frontend factor analysis for speaker verification[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2011, 9(4): 788798.

[7] KIM T, KITTLER J. Locally linear discriminant analysis for multimodally distributed classes for face recognition with a single model image[J]. PAMI, 2005, 27(3): 318327.

[8] MATEJKA P, GLEMBEK O, CASTALDO F, et al. Fullcovariance UBM and heavytailed PLDA in i-vector speaker verification[C]. In Proc. ICASSP. IEEE, 2011: 48284831.

[9] HASAN T, HANSEN J H L. Acoustic factor analysis for robust speaker verification[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2013, 21(4): 842853.

[10] KENNY P. Bayesian speaker verification with heavy tailed priors[C]. In Speaker and Language Recognition Workshop (IEEE Odyssey), 2010:141.

[11] GODFREY J J, HOLLIMAN E C, MCDANIEL J. SWITCHBOARD: telephone speech corpus for research and development[C]. In Proc. ICASSP. IEEE, 1992: 517520.

[12] REYNOLDS D A, QUATERI T F, DUNN R B. Speaker verification using adapted Gaussian mixture models[J]. Digital Signal Processing, 2000, 10(1/3): 1941.