芯東西7月30日消息,在最新MLPerf基準測試中,NVIDIA和谷歌接連公布打破AI性能記錄的消息,使AI戰場上再度彌漫起濃烈的火藥味。

這廂NVIDIA宣布其A100 Tensor Core GPU在加速器的全部8項MLPerf基準測試中展現了最快的市售商用產品性能,那廂谷歌稱其機器學習訓練超級計算機在8項MLPerf基準測試連創6個性能記錄。

谷歌第四代TPU芯片性能也首次披露,得益于硬件創新及軟件優化,TPU v4的性能較TPU v3平均提升2.7倍,此外基于TPU v3的谷歌最強ML訓練超算峰值性能超430 PFLOPs。

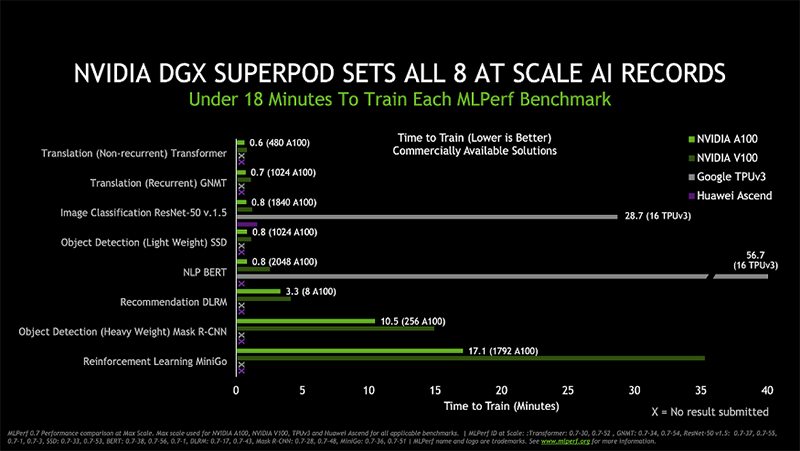

▲NVIDIA DGX SuperPOD集群破MLPerf全部8項AI性能記錄

MLPerf是一個由亞馬遜、百度、Facebook、谷歌、哈佛大學、英特爾、微軟和斯坦福大學等70多家公司和來自領先大學的研究人員組成的聯盟。

MLPerf基準測試是衡量機器學習性能的行業標準,展示了AI行業在處理器、加速器及軟件框架方面的進步。NVIDIA和谷歌分別是通用和專用AI芯片的代表玩家。

在此次基準測試中,NVIDIA是唯一一家在所有測試中均采用市售商用產品的公司,采用了其今年最新發布的旗艦AI產品A100 Tensor Core GPU,以及多個DGX A100系統互聯的龐大集群DGX SuperPOD系統。

▲最新MLPerf基準測試提交的可商用類別部分截圖

其他大多數提交的或為預覽類別(preview category),產品預計幾個月后才會面市;或為研究類別的產品,較長一段時間不會面市。

例如谷歌提交的AI系統即多用于研究、開發或內部使用,或通過谷歌云對外提供,如谷歌第二代和第三代TPU超級計算機現已通過谷歌云對外開放。

谷歌在此次測試中使用的是其第三代、第四代張量處理單元(TPU)以及谷歌最快的機器學習(ML)訓練超級計算機。

在最新MLPerf基準測試中,我們也看到了基于華為昇騰910芯片的兩項提交測試結果。

▲最新MLPerf基準測試提交的研究/開發/內部使用類別部分截圖

MLPerf訓練基準測試結果鏈接:

https://www.mlperf.org/training-results-0-7

01

MLPerf基準測試的八種模型

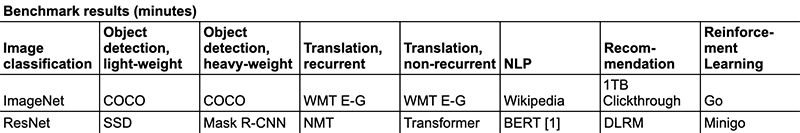

當前MLPerf訓練基準測試包含圖像分類、圖像分割、目標檢測、翻譯等8種機器學習模型,通過測試訓練其中某一模型達到預定性能目標所需的時間(單位為分鐘),來體現其性能。

▲MLPerf訓練基準測試包含的8種機器學習模型

最新版本的MLPerf包括兩個新的測試BERT、DLRM和一個大幅修訂的測試MiniGo。

前沿對話式AI模型BERT是現有最復雜的神經網絡模型之一,常被用作翻譯、搜索、文本理解、問答等任務。

推薦系統是日益普及的一項AI任務,深度學習推薦模型DLRM常被用于在線購物推薦、搜索、社會媒體內容排序等任務。

強化學習模型MiniGo使用了全尺寸19x19圍棋版本,是本輪最復雜的測試,內容涵蓋從游戲到訓練的多項操作。

最新一輪MLPerf訓練基準測試中,提交結果的有9家公司,共提交了138個不同系統的結果,包括商業可用系統,即將發布的預覽系統以及正在研究、開發或內部使用的RDI系統。

02

NVIDIA在市售商用加速器中,刷新全部8項測試AI性能紀錄

根據發布的MLPerf基準測試結果,NVIDIA首款基于Ampere(安培)架構的加速器A100 Tensor Core GPU在市售商用加速器的全部8項測試中,具備最快的AI訓練性能。

在實現總體最快的大規模解決方案方面,利用HDR InfiniBand實現多個DGX A100系統互聯的龐大集群DGX SuperPOD系統,在性能上也開創了8項全新里程碑。

▲NVIDIA A100集群破MLPerf全部8項AI性能記錄

從圖中可見,相較基于NVIDIA V100 GPU的系統,基于A100的系統在全部8項AI性能測試中均有1.5-2.5倍的性能提升。

對比華為昇騰910處理器在圖像分類測試、谷歌TPU v3在自然語言處理(NLP)測試的成績,NVIDIA A100的處理速度依然相對更高。

這已是NVIDIA連續三次在MLPerf中連續第三次展現強勁性能。2018年12月,NVIDIA首次在MLPerf訓練基準測試中創下了6項紀錄,次年7月NVIDIA再次創下8項紀錄。

通過持續發展全新GPU、軟件升級和不斷擴展的系統設計,NVIDIA AI平臺性能得到進一步提升。

測試結果顯示,相較于首輪MLPerf訓練測試中使用的基于V100 GPU的系統,如今DGX A100系統能夠以相同的吞吐率,實現高達4倍的性能提升。

同時,得益于最新的軟件優化,基于NVIDIA V100的DGX-1系統亦可實現高達2倍的性能提升。

▲過去一年半,NVIDIA系統性能提升高達4倍

許多戰略性AI應用已受益于NVIDIA帶來的強大性能,例如阿里巴巴在11月“雙十一”期間創造380億美元的銷售記錄,其推薦系統即使用了NVIDIA GPU,使每秒查詢量達到了CPU的100倍以上。

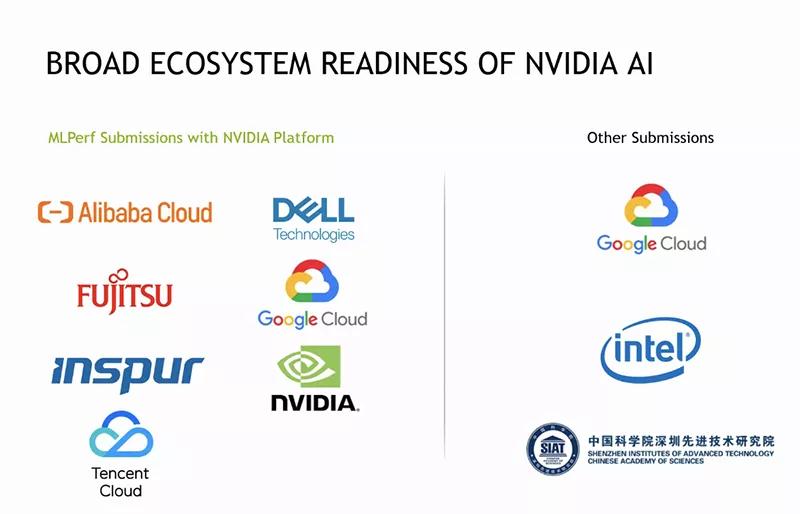

在提交結果的9家公司中,除NVIDIA之外,有6家公司均提交了基于NVIDIA GPU的測試結果,其中包括阿里云、谷歌云和騰訊云三家云服務提供商,以及戴爾、富士通和浪潮三家服務器制造商。

▲采用NVIDIA平臺參與基準測試的NVIDIA合作伙伴

包括這些MLPerf合作伙伴在內的近二十家云服務提供商和OEM組成的生態系統,已采用或計劃采用NVIDIA A100 GPU來打造在線實例、服務器和PCIe卡。

大多數NVIDIA及其合作伙伴在最新MLPerf基準測試中使用的軟件,現已可通過NGC獲取。

03

第四代TPU平均性能提升2.7倍, 谷歌最強ML訓練超算峰值性能超430 PFLOPs

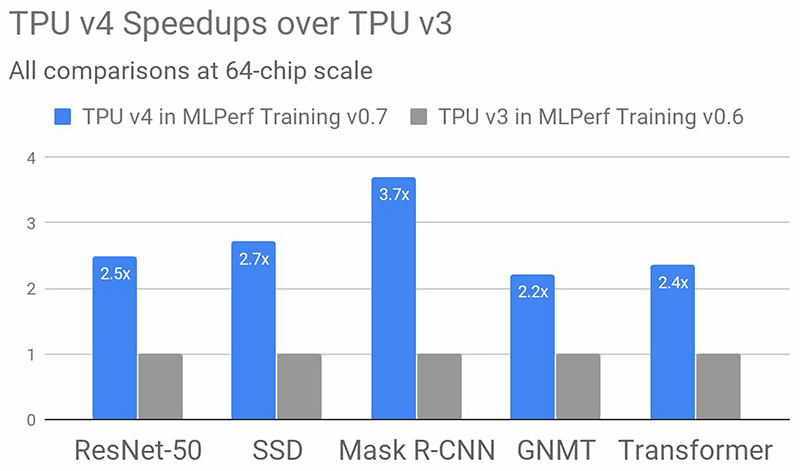

谷歌的第四代TPU ASIC提供了超出TPU v3兩倍的矩陣乘法TFLOPS、內存帶寬和互連技術進步。

基于TPU v4的硬件創新以及軟件優化,基于相同規模64個芯片,谷歌TPU v4的性能相比在MLPerf Training v0.6訓練測試中的TPU v3性能平均提高了2.7倍。

▲谷歌TPU v4在6種模型測試中的性能相比TPU v3平均提高了2.7倍

谷歌很快將發布更多關于TPU v4的信息。

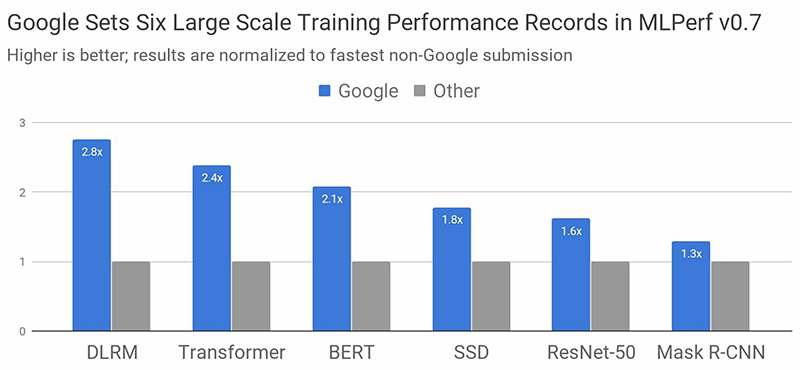

在MLPerf Training v0.7基準測試的所有可用類別中,谷歌提交的最快速度均超過了非谷歌提交的最快速度。

▲MLPerf Training v0.7基準測試的所有可用類別性能表現,無論系統規模大小從8個芯片到4096個芯片,比較都按照總體訓練時間進行歸一化,數值越高越好

在本次MLPerf訓練中,谷歌使用的超級計算機,規模比在之前創下三項記錄的云TPU v3 Pod大四倍。

該系統包括4096個TPU v3芯片和數百臺CPU主機,所有連接通過超高速、超大規模的自定義互連,能提供超過430 PFLOPs峰值性能。

▲在谷歌新ML超級計算機上,所有MLPerf提交均在33秒或更快的時間內完成

在谷歌新ML超級計算機上,無論是使用2048或4096個TPU芯片,所有這些MLPerf測試都在33秒或更快的時間內完成。

谷歌使用TensorFlow、JAX和Lingvo中的ML模型結合XLA實現了這些成績。

TensorFlow是谷歌端到端的開源機器學習框架,XLA是支持所有谷歌MLPerf測試的底層編譯器技術,Lingvo是使用TensorFlow構建的序列模型高級框架,JAX是一種基于可組合函數轉換的新型研究框架。

這些性能成績體現了谷歌在推進機器學習研究方面的進展。

在2015年,谷歌讓一款手機用當時有最先進的硬件加速器需要花費三個多星期進行類似的訓練。僅僅五年時間,谷歌就可以將同一模型的訓練速度提高近5個數量級,這一進展令人相當印象深刻。

谷歌表示,用戶現可通過谷歌云使用谷歌的第二代和第三代TPU超級計算機。

04

結語:AI加速器競賽良性升級

機器學習模型的快速訓練對于研究和工程團隊來說至關重要,而不斷演進的通用及專用AI加速芯片正帶來新的突破。

隨著NVIDIA A100和谷歌TPU v4的問世,AI芯片領域戰況將更為激烈,而這些良性的競爭也將進一步帶動AI相關研究及應用落地的快速發展。